Erkenntnisse und Schlüsse aus einem Experiment mit dem Echtzeitnetz

Was war die grundlegende Idee der Live Twitter Map zu dem Castortransport? Gregor Aisch und ich haben versucht eine Anwendung zu bieten, die nahezu in Echtzeit den Social-Media-Kanal Twitter sowohl mit einem thematischen als auch geografischen Bezug abbildet.Dafür, dass die LiveMap in wenigen Tagen vor dem Castortransport entstand, sind wir sehr zufrieden. Mehr als 30.000 eindeutige Besucher haben die Karte bislang genutzt; was eigentlich als „proof of concept“ gedacht war, erweist sich als praxistaugliche Anwendung. Die Einbettung durch taz.de, die in der Seitenleiste ihres vielbeachteten Castortransport-Tickers darauf hinweist, brachte bislang weit mehr als 10.000 Besucher nur von dort.

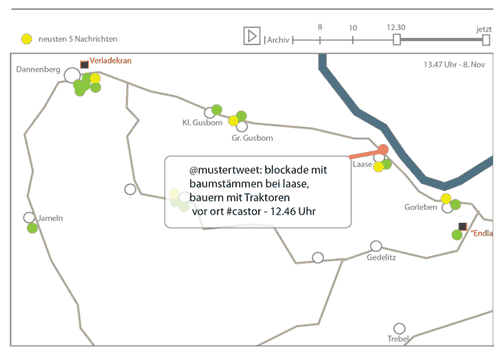

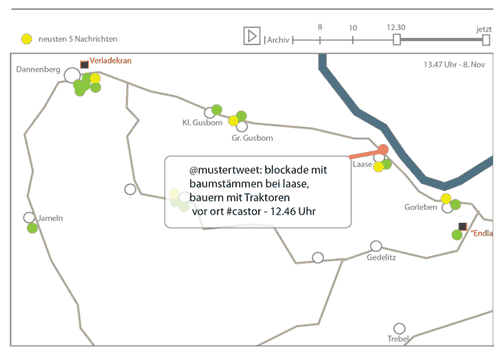

Die Stärke der Karte, das muss eingeräumt werden liegt weniger in ihrer Live-Funktionalität. Die klappt manchmal nicht reibungslos. Doch die Archivfunktion wird auch in der kommenden Zeit einen nützlichen Überblick bieten, wie sich die Situation im Wendland und an der Transportstrecke entwickelte: Es lässt sich im Nachhinein in die Situationen eintauchen; Nachrichten von vor Ort dank der GPS- Funktion lesen und eben viele Tweets aufrufen, die sich auf castorrelevante Ortsangaben bezogen.

Was haben wir gelernt?

Sicher lässt sich die App noch ausbauen, der ein oder andere Bug (Programmierfehler) ausbügeln und die Usability erhöhen.

Aber das größte Problem – ein Klassiker – war die Last auf dem Server. Da die Anwendung am Freitag und Samstag von zeit.de direkt in Artikel sowie zeitweise von taz.de auf der Startseite eingebunden wurde, ging der virtuelle Server, auf dem die App gehostet wurde, in die Knie (Probleme aufgrund des Ansturms hatten castorticker.de und taz.de zeitweise auch). Glücklicherweise wurde uns Samstagabend ein mächtigerer Server zur Verfügung gestellt, der seitdem die Anforderungen gut verarbeitet. (Am Dienstagvormittag gab es weitere Probleme, die jetzt wieder gelöst sind).Über Aspekte und Herangehensweise bei der Programmierung, etwa des Anzapfens der Twitter-API, schreibt Gregor Aisch in seinem Blog. Er hatte vergangene Woche in einem Kraftakt innerhalb weniger Tage die funktionale App gebaut.Für uns erstaunlich ist, dass laut der Auswertung der Nutzung per Piwik die Einbettungs-Funkionalität der Anwendung kaum in Anspruch genommen wurde.

Netz von Sensoren und Filtern gegen das Rauschen

Wir legen auf den allgemeinen Twitterstream, der per Schnittstelle (API) abrufbar ist, mehrere Filter an: Alle Tweets mit einem bestimmten #hashtag werden durchgelassen. Die wiederum werden auf Orte aus dem Wendland und entlang der Transportstrecke abgeklopft. Anhand der Ortsnamen – die als Sensoren dienen – und ihrer Geokoordinaten, etwa 80, werden die Tweets dann gemappt (eine Karte dazu hier; die KML-Datei gibt es als Download).

Eine ausgewählte Liste von etwa 20 Accounts (@castorticker, @greenpeace_de usw.) werden direkt durchgelassen und auf Ortsangaben gecheckt.Twitter erlaubt es, den Standort des Users, der per GPS vom Mobiltelefon / Smartphone erhoben wird, mit zu übermitteln. Ein Filter lässt zu, den Umkreis von 25Km um einen Ort wie Dannenberg zu definieren. In diesem Radius werden alle Twitternachrichten mit GPS-Note auf der Karte eingetragen.

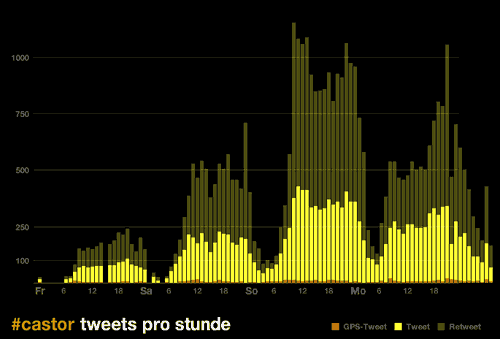

Dieses Netz von Filtern und geografischen Sensoren ließ zu den Hochzeiten am Sonntag und Montag bis zu 400 Tweets pro Stunde durch. Retweets (RT) haben wir nicht durchgelassen; deren Zahl betrug meist das Doppelte bis Dreifache der ursprünglichen Kurznachrichten. Bei Gregor Aisch findet sich eine stetig aktualisierte Auswertung der Anzahl der Tweets (siehe Grafik oben).

Was interessiert am Live-Web?

Außer Facebook und Konsorten lassen sich RSS-Feeds und andere Schnittstellen, die neue Informationen ins Netz hinausdrücken (push) als das Echtzeitnetz, das Live-Web bezeichnen.Twitter als puristisches soziales Netzwerk ist für eine Analyse, besonders wenn es um Vorgänge über eine räumliche Ausdehnung geht, ideal. Die kurze Art der Nachricht, die auf die Erfahrung der User mit SMS aufbaut plus der Übermittlung von Links, ermöglicht eine kondensierte Kommunikation – die eben auch mobil und vor Ort geschehen kann.Die Sortierung nach den #hashtags – einte etablierte Konvention unter den Twitternutzern – erlaubt einen unmittelbaren Zugriff auf Themenstränge, angeordnete auf einer Zeitleiste. Daran liegt die Praktikabilät von Twitterclients wie Tweetdeck, die es erlaubt, mehrere thematische Kanäle parallel beobachten zu können.

Eine Anwendung wie die Twitter LiveMap stösst allerdings auch wegen der Beschaffenheit solch eines „Microbloggings“ an seine Grenzen. Bloggen kann eben eine ganze Bandbreite von Inhalten bedeuten; bei Twitter fallen manche Genres heraus, wie etwa Reportagen, Analysen, Glossen. Die Tweets lassen sich in folgende Kategorien einteilen, wobei es selbstredend auch Mischformen gibt:

- Meldung – Hinweise zu aktuellen Vorgängen

- Report – Eindrücke von vor Ort

- Material – Links auf Bilder, Texte, Videos

- Status – Was macht der Sender gerade, was hat er vor

- Bemerkungen – Kommentare, Empfindungen, Bonmots, Sarkasm

- Aufforderungen/Fragen – „kommt alle“, „wer weiß/hat?“ etc.

Ein Teil davon ist für das Beobachten von Vorgängen irrelevant. Mit dem geografischen Filter, den wir auf die meisten Tweets legen, sortieren wir beispielsweise die meisten Bemerkungen heraus. Doch muss für zukünftige Nutzung so einer Karte über das Verfeinern der Filter nachgedacht werden. Wir haben in Richtung eines Scoring-Systems gedacht, das die Relevanz besser bewerten kann; eine automatische semantische Vorsortierung wäre auch nicht zu verachten. Probleme bereiten etwa Ortsangaben wie „Gorleben“ – da dieser Ortsname auch als Synonym benutzt wird.

Ist das Datenjournalismus?

Was ist die Zukunft von solchen Anwendungen? Können sie als Datenjournalismus bezeichnet werden? Letztere Frage lässt sich mit ja beantworten. Große Datenströme werden sortiert, gefiltert und aufbereitet interaktiv dargeboten. Neben der unmittelbaren Anwendung selbst, lassen sich die Daten gleichfalls genauer auswerten und über die gewonnen Erkenntnisse berichten – das haben wir parallel in einem Blog zur LiveMap versucht. Und schließlich lassen sich die Rohdaten veröffentlichten. Dies werden wir noch tun – wir legen derzeit alle Tweets, auch RT, in einer Datenbank ab, bevor wir sie gefiltert ausgeben.Hier zeigt sich übrigen schon der Knackpunkt von Twitter in Zusammenhang mit politischem Aktivismus. Jedermann kann eben diesen Kommunikationskanal monitoren und auch im Nachhinein, teilweise mit Aufenthaltsort des Nutzers, auswerten. Dies sollten Aktivisten auf jeden Fall in der Nutzung von Twitter beachten.

Und was die Zukunft angeht: Die Aufbereitung des Live-Web als Teil der Onlineberichterstattung dürfte zunehmen – siehe etwa die Twitteranwendung der NYT zu den Midterm-Elections. Eine Anwendung wie die LiveMap bietet sich nur für bestimmte Events an – als Versuchsumgebung ist so ein riesiges ernstes Geländespiel wie die Demonstrationen gegen den Castortransport ideal. Eine Veranstaltung wie das Oktoberfest dagegen ist durch ihre Konzentrierung auf einen Ort ungeeignet.Wie gesagt, das Echtzeitnetz dürfte und sollte mehr Gegenstand von Berichterstattung werden. Denn Journalismus hat immer schon darüber berichten zu versucht, was Leute treiben und interessiert. Die stetig zunehmende Nutzung der sozialen Netzwerke gehört zweifelsohne dazu. Hier liegt auch ein mögliches Alleinstellungsmerkmal für Online-Medien: Sie haben die Mittel an der Hand, diese Kommunikationsströme dem Medium entsprechend zu durchdringen und zeigen.

(Erschienen auf datenjournalist.de 9.9.10)